目次

第1弾では「パーソナルAIスーパーコンピュータ」というコンセプトを、第2弾ではその心臓部である「GB10 Grace Blackwell Superchip」と「128GB統合メモリ」について解説しました。

第3弾となる今回は、NVIDIA DGX Spark™が単なる高性能ワークステーションではなく、「デスク上のデータセンター」として機能する理由の核心に迫ります。

それは、デスクトップ機としては異例の「200GbE 高速ネットワーク」と、開発から本番環境への移行をシームレスにする「統合されたソフトウェアスタック」の存在です。

特にソフトウェア面では、多くの開発者が直面する「環境構築の泥沼」を回避し、AIモデルの開発・検証(Prototyping)を即座に開始できる仕組みが整っています。

今回のコラムでは、その具体的な中身と、誤解されがちなライセンスの考え方について正しく理解できるよう深掘りしていきます。

▼図1 DGX Sparkの超高速ネットワークと統合ソフトウェアエコシステムの位置づけ

1. 拡張性の要:NVIDIA ConnectX-7とスケーラビリティ

DGX Sparkの背面には、一般的なPCには見られない特徴的なインターフェースが存在します。それが、エンタープライズサーバーグレードのネットワークアダプタ「NVIDIA ConnectX®-7」です。1-1. デスクトップ機に「200GbE」という衝撃

DGX Sparkには、通常の10GbE(RJ-45)ポートに加え、200GbEクラスの高速ネットワークに対応した NVIDIA ConnectX-7(QSFPポートx2) が搭載されています。 一般的なワークステーションのネットワーク帯域が1~10Gbpsであることを考えると、これは桁違いのスペックです。ではなぜ、デスクトップ機にこれほど広帯域なネットワークが必要なのでしょうか?

▼図2 200Gbpsがもたらす、デスクトップのスケーラビリティ

その答えは「スケーラビリティ(拡張性)」と「分散処理の再現」にあります。

1-2. DGX Spark同士の直接接続:2台構成でスケールアウト

DGX Sparkの最もユニークな機能の一つが、このConnectX-7を用いた2台のDGX Sparkの直接接続(クラスタリング)です。 QSFPケーブル1本で2台のDGX Sparkを接続することで、以下の拡張が可能になります。• 性能について

2台構成により、分散処理が可能なワークロードでは演算性能をスケールアウトさせることができます。

特に、モデル並列やデータ並列など、並列化に適した推論・学習処理においては、FP4を活用した推論・学習を前提としたワークロードで、2台分の演算リソースを効果的に利用する構成が可能です。

• メモリについて

2台構成では、合計で最大256GBのメモリ容量を分散メモリとして利用することができます。

分散学習や並列推論といった手法を用いることで、単体構成では扱えない、より大規模なモデルやデータセットへの対応が可能になります。

これにより、モデル構成や量子化方式、並列化手法などの条件に依存しますが、単体構成では扱いきれなかった最大4,050億(405B)パラメータ級のLLMを推論検証の対象にできる可能性があります。(405Bは検証用途を想定)

クラウド上のGPUインスタンスを借りることなく、手元の環境だけでこの規模感のモデル挙動を検証できる点は、機密データを扱うプロジェクトや、クラウド利用に制約のある環境において、非常に大きなメリットとなります。

▼図3 2台のDGX Sparkの接続について

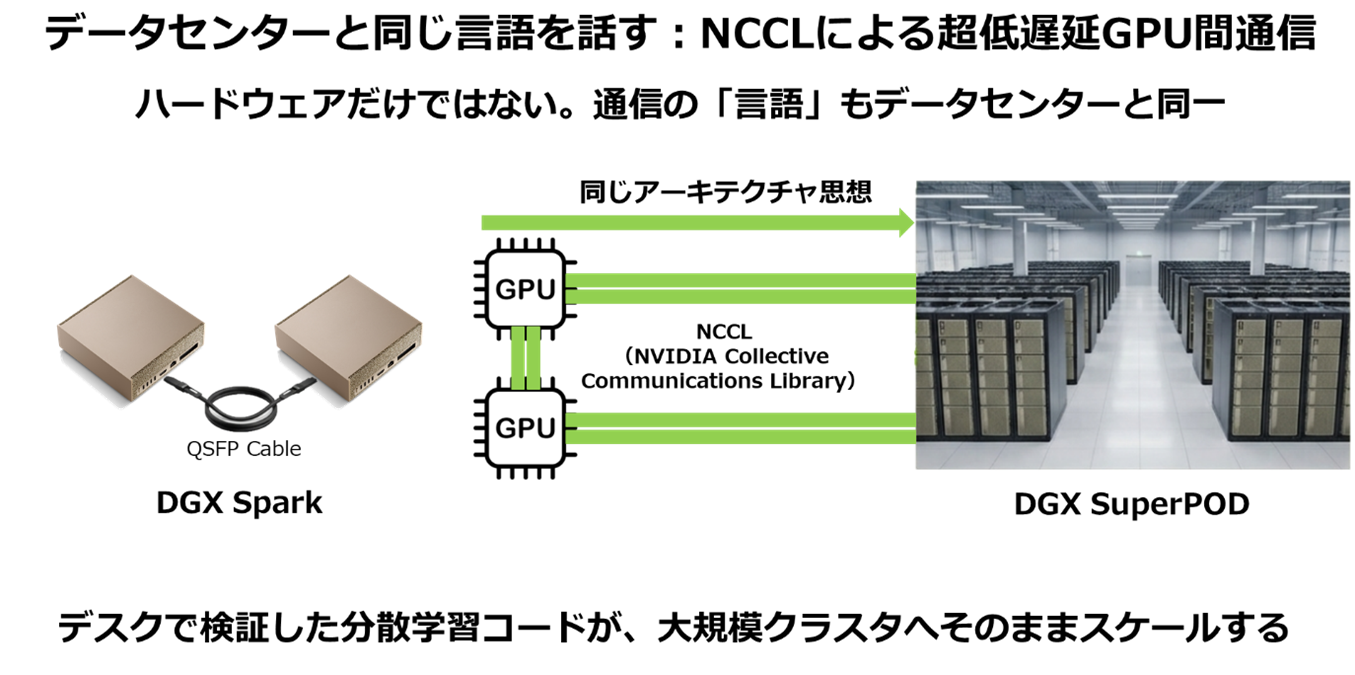

1-3. NCCLによる高速なGPU間通信

ハードウェアとしての接続だけでなく、その裏側で動く通信ライブラリも重要です。DGX Sparkは、NVIDIAが開発したマルチGPU通信ライブラリ「NCCL(NVIDIA Collective Communications Library)」をサポートしています。通常、複数台のコンピューターで処理を分散させる場合、通信の遅延がボトルネックとなり、GPUの性能を出し切れないことがあります。

しかし、DGX SparkはConnectX-7とNCCLを組み合わせることで、低遅延かつ高スループットなGPU間通信を実現しています。 これは、NVIDIA H100 GPUなどを搭載した大規模なDGX SuperPODなどのデータセンターと同じアーキテクチャです。つまり、デスク上のDGX Spark2台で検証した分散学習のコードは、将来的に大規模なクラスタへ移行する際にも、そのままのロジックでスケールさせることが可能になるのです。

▼図4 NCCLによる高速なGPU間通信

2. 開発効率を最大化する:DGX Sparkソフトウェアスタック

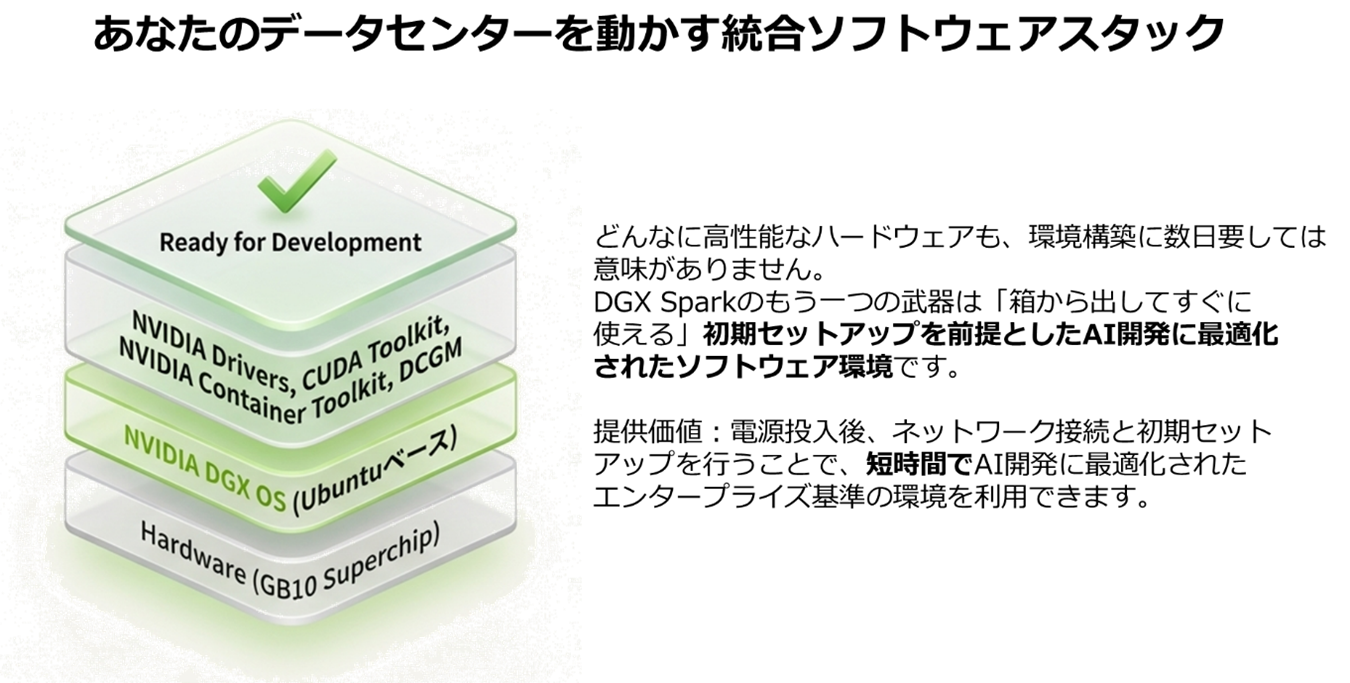

ハードウェアがいかに高性能でも、環境構築に数日かかってしまっては意味がありません。DGX Sparkのもう一つの強力な武器は、「初期セットアップが最小限」のAI開発に最適化されたソフトウェア環境です。 ここでは、標準搭載されるものと、別途ライセンスが必要なものの違いを整理しながら解説します。2-1. DGX OS:AI専用にチューニングされた基盤

DGX Sparkには、Ubuntu LinuxをベースにNVIDIAがAIワークロード向けに最適化した「NVIDIA DGX™ OS」がプリインストールされています。 これには以下のコンポーネントが最初から含まれています。NVIDIA Drivers & CUDA Toolkit:バージョン整合性に悩まされることなく、最新のBlackwellアーキテクチャに最適化されたドライバが利用可能。

NVIDIA Container Toolkit:DockerコンテナからGPUをシームレスに利用するためのランタイム。

Data Center GPU Manager (DCGM):GPUの稼働状況や健全性を監視するツール。

一般的な自作PCやワークステーションでAI環境を構築する場合、ドライバの選定やライブラリの依存関係解消など、開発を始める前に「環境構築の沼」にハマることが少なくありませんが、DGX Sparkは、電源を入れた瞬間から最適化された環境が手に入ります。

▼図5 DGX Sparkのソフトウェアスタックについて

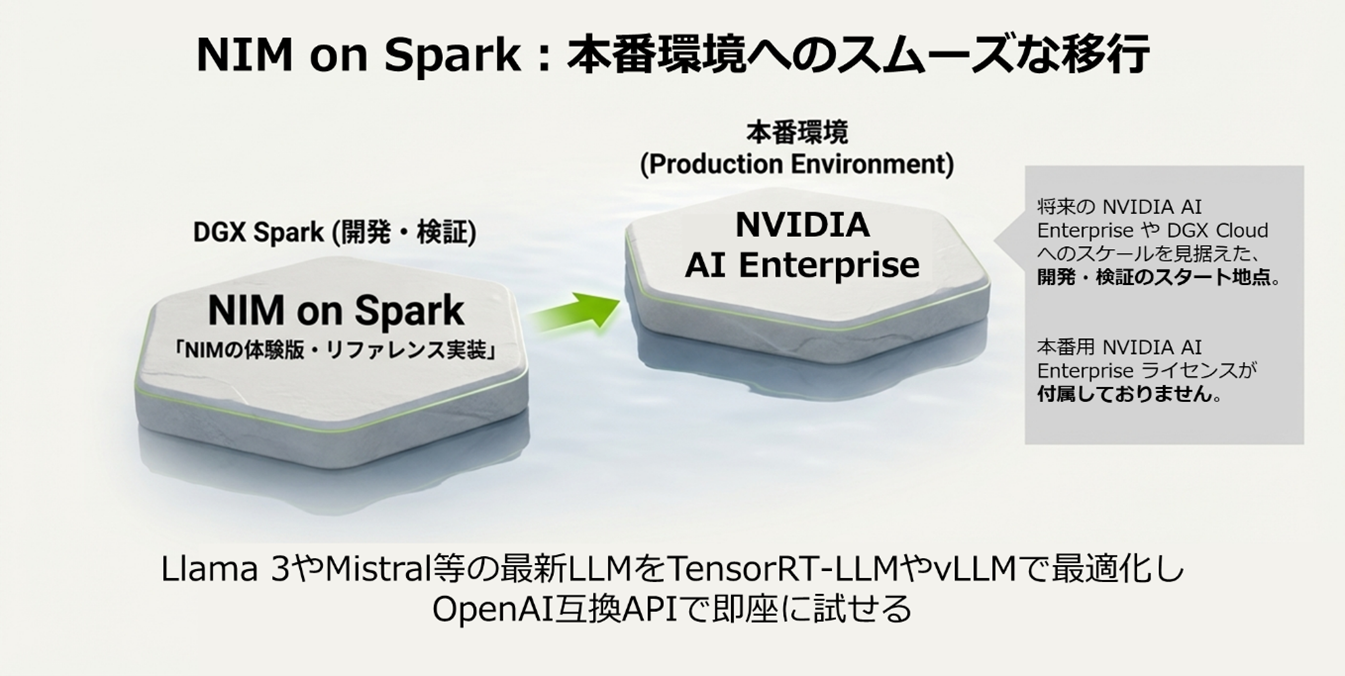

2-2. NIM on Spark:ローカルで体験する「推論最適化の最前線」

DGX Sparkのソフトウェアエコシステムを語る上で欠かせないのが、「NIM on Spark」です。 これは、NVIDIAが提供する公式開発者向けスタートガイド(※外部サイトに飛びます)を通じて利用できる、推論最適化技術のリファレンス実装・体験環境です。NVIDIA NIM™(NVIDIA Inference Microservices)は、本来NVIDIA AI Enterprise(以下、NVAIE)において提供されるエンタープライズ向け推論マイクロサービス群ですが、DGX Sparkがその一部コンセプトや技術を、学習・検証用途としてローカル環境で体験できる形で提供しています。

具体的には、Playbooks(2.4 で紹介) に従うことで、Llama 3やMistralなどの最新LLMを、TensorRT-LLMやvLLMといった最適化エンジンと組み合わせ、OpenAI互換API形式の推論サーバーとして立ち上げることが可能です。

なお、利用にあたってはNVIDIA NGCアカウントおよびAPIキーが必要となります。

そして重要なのは、DGX Sparkが「本番向けエンタープライズ製品をそのまま提供する」ことを目的としているのではなく、将来的にNVAIEやNVIDIA DGX™ Cloudへとスケールするための開発・検証の起点を提供している点です。

DGX Spark上でNIM on Sparkを使って構築・検証した推論パイプラインや API設計は、本番環境においてNVAIEを採用した際にも、スムーズに移行することができます。

▼図6 NIM on Sparkの概要

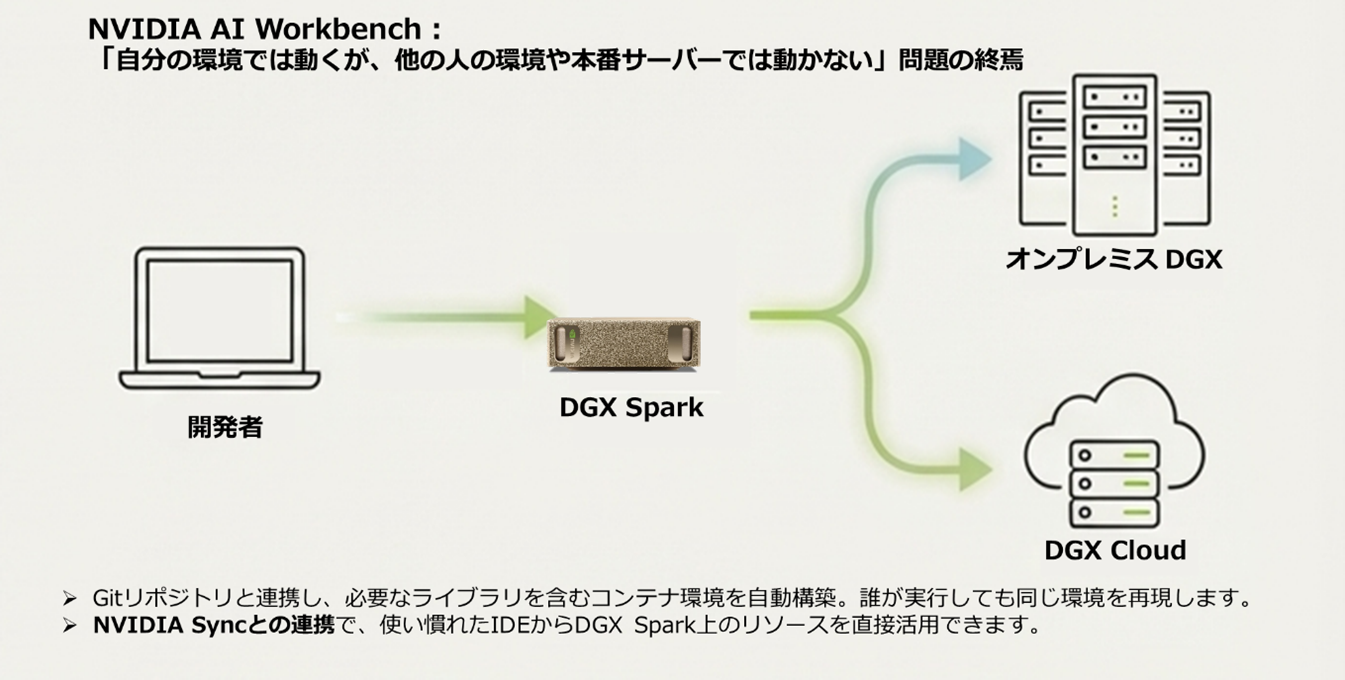

2-3. NVIDIA AI Workbench:プロジェクトの「再現性」と「移植性」を確立する

AI開発の現場で頻発する「自分の環境では動くが、他の人の環境や本番サーバーでは動かない」という課題を解決するのが、NVIDIA AI Workbenchです。DGX SparkはAI Workbenchと組み合わせることで、ローカルで作った実験環境を“再現可能な形”で共有し、そのままDGX Cloudやデータセンターへ展開するための土台になります。これが今回のテーマである「デスク上のデータセンター」を運用面から支える要素のひとつです。

• 環境の自動構築とコンテナ化

AI Workbenchは、Gitリポジトリと連携し、プロジェクトに必要なライブラリ、ドライバ、設定を含んだコンテナ環境を自動的に構築します。これにより、誰がどこで実行しても同じ環境が再現されます。

• ハイブリッドな開発フロー

DGX Spark上でAI Workbenchを使って開発したRAGアプリケーションや学習モデルは、ボタン操作一つでDGX Cloudやオンプレミスのデータセンターへ複製・移動(マイグレーション)が可能です。

• NVIDIA Syncとの連携

ローカルPC(Windows/Mac)からDGX Sparkへ接続する際は、NVIDIA Syncを利用します。SyncはSSHアクセスの管理や開発ツールの起動を一元化でき、VS Codeなど普段のIDEからDGX Spark上の環境をシームレスに扱えます。

AI Workbenchは、DGX Sparkでの「試作」を、データセンターでの「本番」へとスムーズに繋ぐための架け橋となる重要なツールです。

▼図7 NVIDIA AI Workbenchの紹介

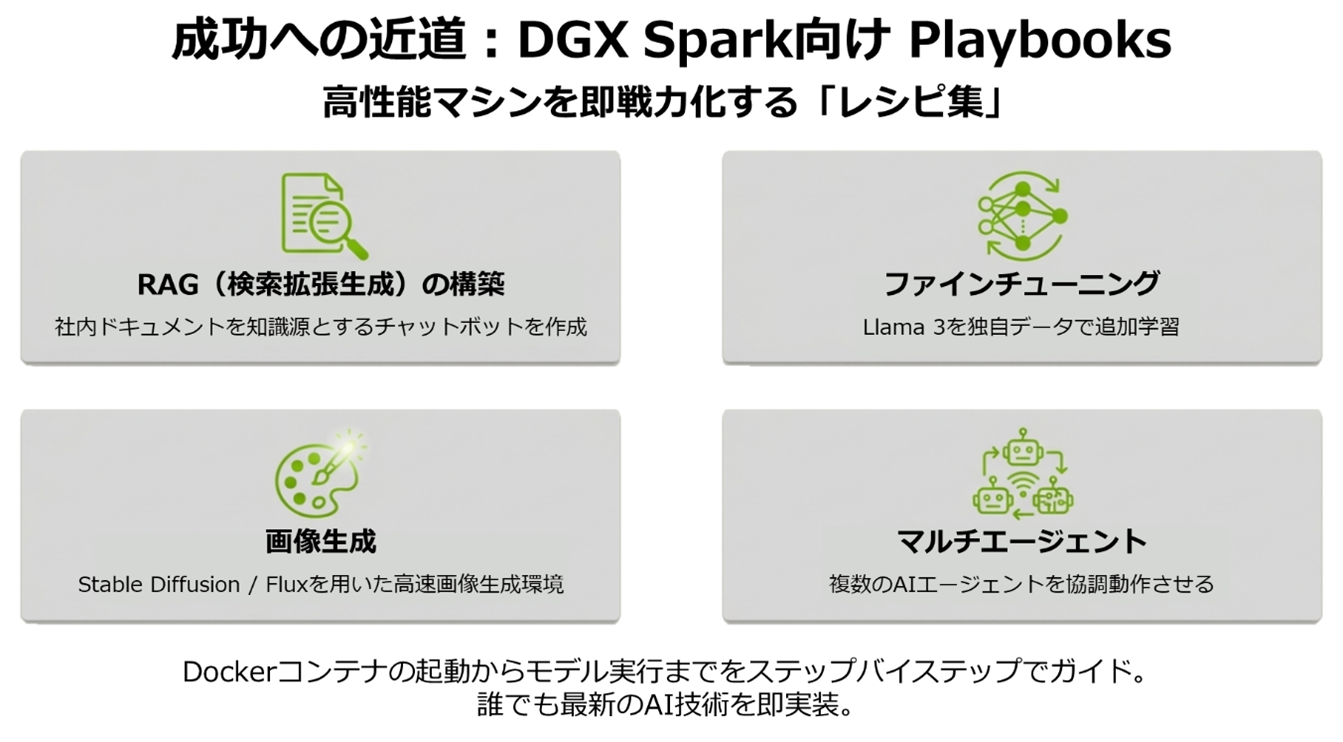

2-4. Playbooks:成功への近道

「高性能なマシンはあるが、何から始めればいいかわからない」という課題に応えるのが、NVIDIAがDGX Spark向けに提供している Playbooks(手順付きワークフロー)です。 これは特定のユースケースを実現するための「レシピ集」であり、以下のようなワークフローをすぐに試すことができます。• RAG(検索拡張生成)の構築:社内ドキュメントを読み込ませたチャットボットの作成

• ファインチューニング:Llama 3などのモデルを独自データで追加学習させる手順

• 画像生成:Stable DiffusionやFlux(拡散モデル)を用いた画像生成環境の構築

• マルチエージェント:複数のAIエージェントを協調動作させるデモ

これらのPlaybooksに従うことで、Dockerコンテナの立ち上げからモデルのダウンロード、実行までをステップバイステップで実施でき、つまずくことなく最新のAI技術を実装できます。

▼図8 DGX Spark向けPlaybooks

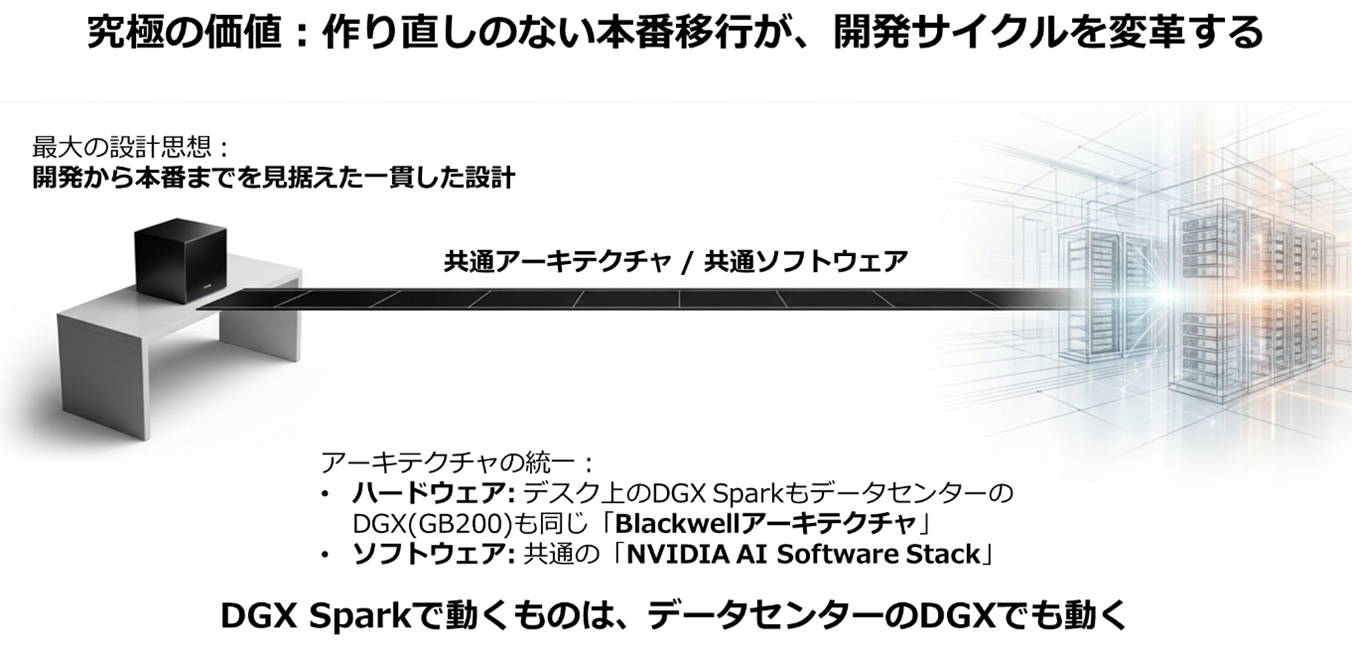

3. 「デスクからデータセンターへ」:シームレスなスケーリング

第1弾から通してDGX Sparkを見てきましたが、このデバイスの最大の設計思想は「環境の一貫性(Consistent Environment)」にあります。3-1. アーキテクチャの統一

DGX Sparkは、デスクトップサイズでありながら、データセンター向けの巨大なDGXシステム(NVIDIA DGX GB200 NVL72など)と同一の「Blackwellアーキテクチャ」世代に基づくプログラミングモデルと「ソフトウェアスタック(CUDA、DGX OS等)」を採用しています。 これは、DGX Sparkで動くコードは、データセンターのDGXでもそのまま動くことを意味します。異なるハードウェアやOS間での移植作業に時間を費やす必要はありません。▼図9 アーキテクチャの統一

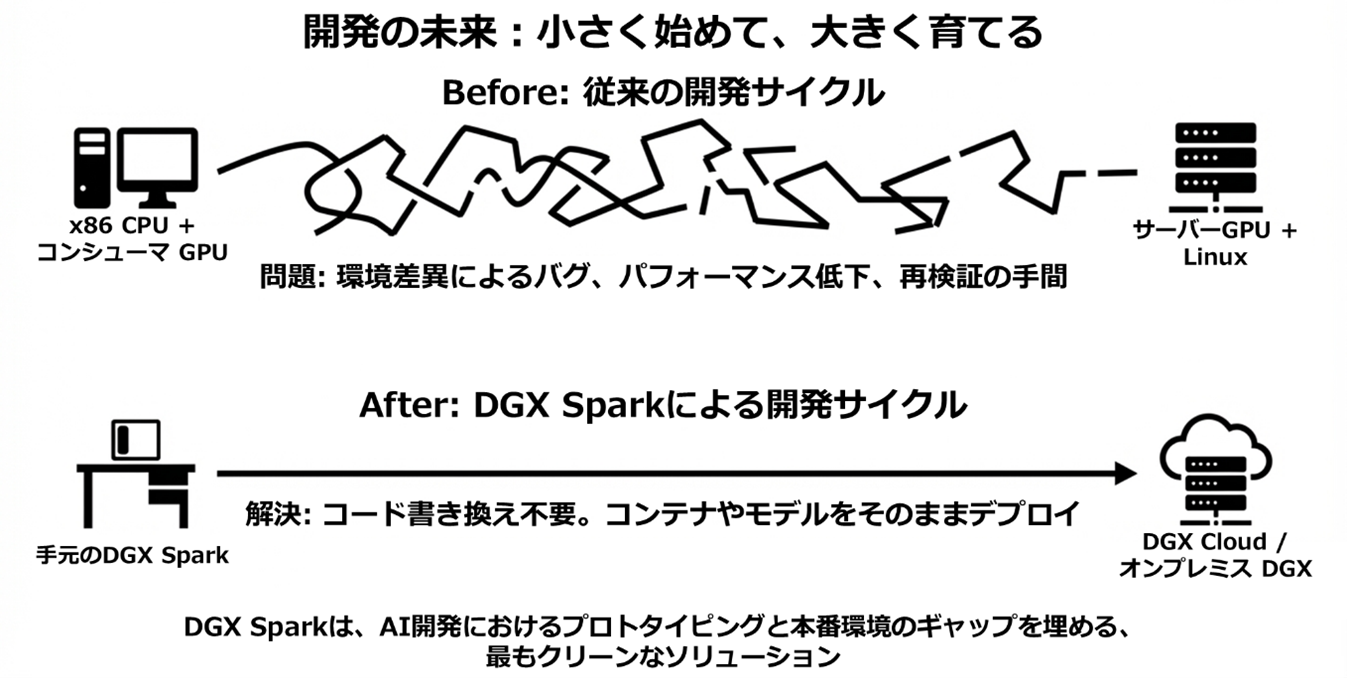

3-2. コード変更不要のデプロイ

従来のAI開発では、手元のPC(x86 CPU + コンシューマーGPU)で開発したコードを、本番環境(サーバーグレードGPU + Linux)に移行する際、環境の差異によるバグやパフォーマンス低下に悩まされることがありました。 DGX Sparkを使うと、開発・検証環境と本番環境のソフトウェアスタックが統一されているため、多くのケースでコードを変更することなくデプロイが可能です。コードの書き換えや再検証の手間を最小限に抑え、「小さく始めて、大きく育てる」という理想的な開発サイクルを実現します。▼図10 コード変更不要のデプロイ

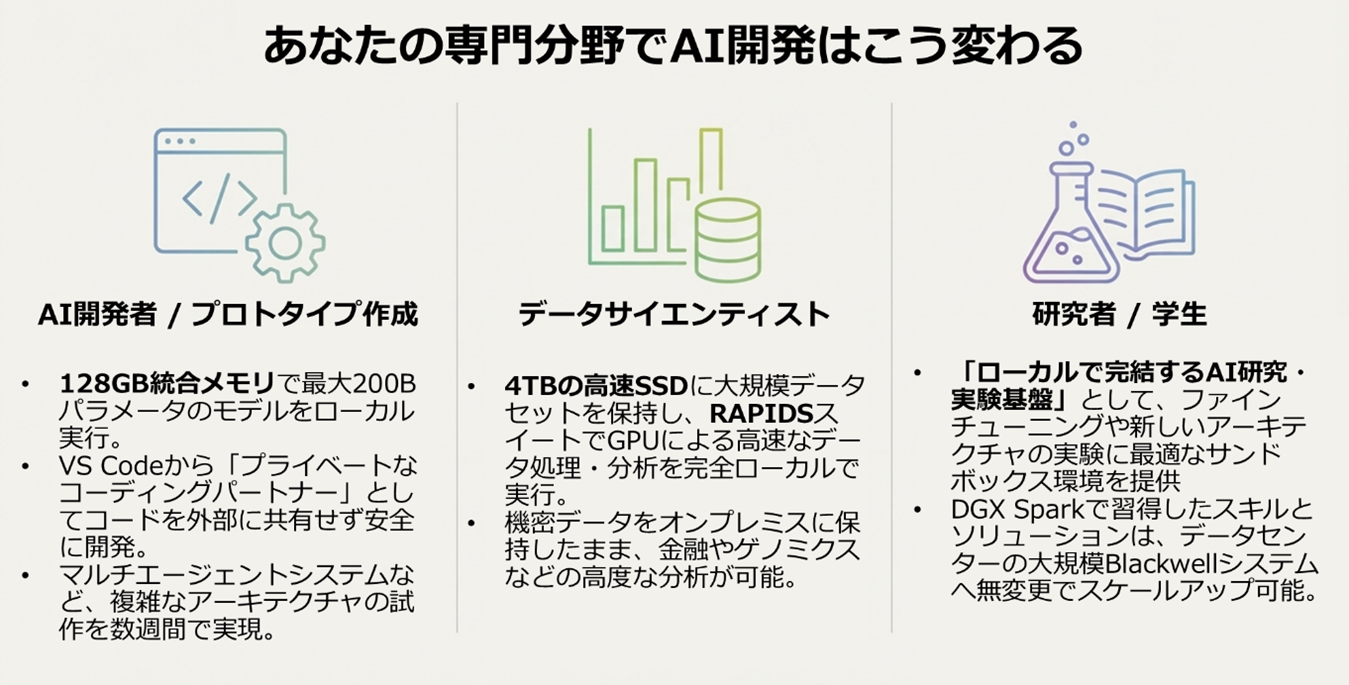

4. まとめ:AI開発の「現在」と「未来」をつなぐ架け橋

第1弾:AI開発の課題(コスト・セキュリティ・リソース)を解決する「パーソナルAIスーパーコンピュータ」というコンセプト第2弾:GB10 Grace Blackwell Superchipと128GB統合メモリがもたらす、巨大モデル(最大2,000億パラメータ)をローカルで扱うための圧倒的なポテンシャル

第3弾:ConnectX-7による2台連結(256GBメモリ空間)への拡張と、データセンターと一貫性のあるソフトウェアエコシステム

今回ご紹介した高速ネットワークとソフトウェアスタックは、DGX Sparkを単なる「高性能な箱」から、「デスク上のデータセンター」へと価値を引き上げる重要な要素です。 NIM on SparkやAI Workbenchを活用することで、開発者は環境構築の手間から解放され、即座にPoC(概念実証)を開始できます。そして、そこで開発したアプリケーションは、コードを書き換えることなく、将来的にNVAIEが稼働する大規模なサーバーやクラウドへシームレスに展開可能です。

DGX Sparkは、手元のデスクで「小さく始め(Start Small)」、必要に応じて「大きく育てる(Scale Big)」ことができる、AI開発の理想的なエントリーポイントです。 クラウドの待機時間に悩まされることなく、セキュリティを気にせず、思いついたアイデアを即座に試行錯誤できる環境。これこそが、これからのAI開発者に求められる最大の武器となるでしょう。

▼図11 DGX Sparkで変えるAI開発環境

DGX Sparkは、あなたのデスクから次のイノベーションを「点火(Spark)」させる準備ができています。

関連ページはこちら:

-[NVIDIA DGX Sparkとは?~超小型スパコンの誕生秘話~ スペックや強みもご紹介]

-[NVIDIA DGX Sparkとは?②~FP4×128GB統合メモリの実力~]

-[NVIDIA DGX Spark 製品ページ]

-[NVIDIA DGX Spark 専用のご購入・お問い合わせフォーム]

-[NVIDIA DGX Spark のよくある質問]

【筆者情報】

菱洋エレクトロ株式会社 ソリューション事業本部

小宮敏博

最終更新日: