目次

1. はじめに

生成AIや科学技術計算の話題を耳にする機会が、この一年で一段と増えました。裏側で要となっているのがGPUであり、そのGPUを汎用計算で使いこなすための実行基盤がNVIDIAのCUDA®(Compute Unified Device Architecture)です。本稿では、CUDAとCompute Capabilityを簡単に解説し、Ubuntuでの導入手順まで説明します。2. CUDAとは

CUDAは、NVIDIA GPUを汎用計算(GPGPU)に使うためのアーキテクチャです。C/C++にGPU拡張を加えたコンパイラ(nvcc)とランタイム(cuda-runtime)を中心に、各種ライブラリとツールがひと揃えになっています。

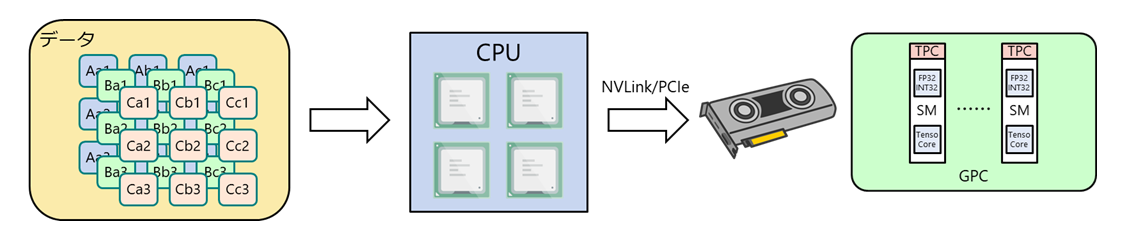

イメージとしては、CPU(ホスト)がGPU(デバイス)に仕事を投げ、GPU上の数千スレッドが一気に計算をさばく二層モデルで動作します。行列演算がボトルネックになりやすい分野(ディープラーニング、シミュレーション、金融など)で効いてくる仕組みです。

3. バージョンとCompute Capability

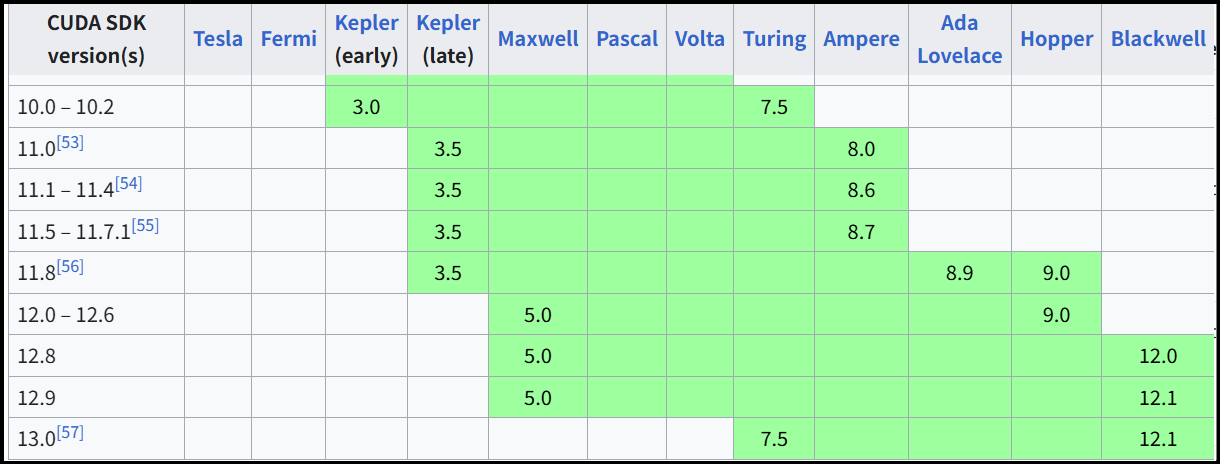

つまずきやすいのが、CUDAのバージョンとCompute Capability(CC)の関係です。CUDAは、ソフトウェア一式のバージョン、CCはGPUハードウェアの世代・命令セット・機能群を示す指標です。ざっくり言えば「このCUDAは、CCいくつ以上のGPUを対象にしていますか?」という対応表があります。注意すべき点としては、同じアーキテクチャ内でもCCが細かく分かれる場合もあるという事です(NVIDIA Ampereだと8.0/8.6/8.7など)。

参照:https://en.wikipedia.org/wiki/CUDA#GPUs_supported

※外部リンクに飛びます

以下は代表例となりますので、目安として眺めていただければ十分です。厳密な機能差分は、実案件ごとに公式ドキュメントで当たるのが安全です。

| Compute Capability | Architecture | GPU例 | Toolkitでの初登場 |

|---|---|---|---|

| 8.0 | Ampere | NVIDIA A100/NVIDIA A30 | CUDA 11.0 |

| 8.6 | Ampere | NVIDIA RTX™ 30xx | CUDA 11.1 |

| 8.7 | Ampere | NVIDIA® Jetson Orin™/Orin NX/Nano | CUDA 11.5 – 11.7.1 |

| 8.9 | Ada Lovelace | NVIDIA RTX™ Ada/NVIDIA L40 GPU | CUDA 11.8 |

| 9.0 | NVIDIA Hopper™ | NVIDIA H100 GPU/NVIDIA H200 GPU/NVIDIA GH200 Grace Hopper™ Superchip | CUDA 11.8(Hopper対応追加) |

| 12.0 | NVIDIA Blackwell | NVIDIA DGX™ GB200/NVIDIA GB200 NVL72 | CUDA 12.8 |

| 12.1 | Blackwell | NVIDIA RTX™ 50xx/NVIDIA RTX PRO™ 6000 Blackwell Server Edition | CUDA 12.9以降 |

実装世代ごとの微差があるため、必要機能が決まっている場合はCUDA Toolkit Documentationでの最終確認をおすすめします。

4. CUDA 13のポイント

2025年8月6日にCUDA Toolkit 13が公開されました。配列全体への高水準操作が強化され、NumPyに近い書き味でGPU計算を書ける場面が増えたのが嬉しいポイントです。一方で互換性は整理が進み、対象はCC 7.5(Turing)以降となりました。プラットフォーム面ではNVIDIA DGX Spark™対応を足場にARM側の選択肢が広がり、JetsonもJetPack 7.0以降でCUDA 13を同梱予定です(Orinの扱いは現時点で限定的です)。Linux対応もRHEL 10.0/9.6、Fedora 42、Debian 12.10、Rocky 10.0/9.6などが追加され、企業導入の下回りが整ってきた印象です。

5. CUDAインストール手順(Linux/Ubuntu)

Ubuntu系でのネットワークインストールについて説明します。社内環境では管理者権限やプロキシ設定が必要なことがあるため、手順は現場ルールに合わせて読み替えてください。以下のNVIDIAの公式を参照しています。

参照:CUDA Installation Guide for Linux — Installation Guide for Linux 13.0 documentation

※外部リンクに飛びます

5-1. cuda-keyringの導入

まずはリポジトリ署名鍵と設定を一括で入れます。最新版は次のインデックスで確認してください。https://developer.download.nvidia.com/compute/cuda/repos/

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

5-2. パッケージの確認

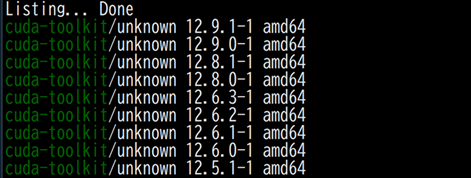

リポジトリ情報を更新し、インストール可能なToolkitを一覧します。画面イメージのように複数バージョンが出るはずです。sudo apt update

sudo apt list -a cuda-toolkit

5-3. CUDA Toolkitのインストール

導入は「最新をそのまま」か「バージョン固定」かの二択です。検証や再現性を重視する本番系では、固定を推奨します。# バージョン指定なし(最新)

sudo apt-get -y install cuda-toolkit

# 例:バージョン固定(12.9)

sudo apt-get -y install cuda-toolkit-12-9

6. 運用・開発の要点

導入後は、ドライバとToolkitの整合、そしてGPUのCCを軸に互換を管理します。ドライバはnvidia-smi、コンパイラはnvcc --versionで手早く確認できます。Toolkit更新に合わせてGPU側の対応が要るケースもあるため、「対象GPUのCC」と「必要なCUDA機能/バージョン」は案件開始時に固定しておくと話がぶれません。コンテナ運用なら、ベースイメージのCUDAタグを固定し、ホストドライバとの対応表に沿って更新タイミングを決めるとトラブルが減るでしょう。7. よくある質問

Q. Compute CapabilityとCUDAの関係は何か。A. CUDAはソフトウェア(コンパイラ/ランタイム)のバージョン、Compute CapabilityはGPUハードウェアの世代・機能を示す。互換は「CUDAバージョンが対象とする最小CC以上」で定義される。

Q. どのGPUでCUDA 13が動作するのか。

A. 原則としてCC 7.5(Turing)以降に対応するが、機能単位の対応差がある。詳細は公式ドキュメントとリリースノートで確認するのが確実。

8. まとめ

CUDAはGPUを汎用演算に生かすための基盤であり、互換は「Toolkitのバージョン×GPUのCompute Capability」の組み合わせで決まります。CUDA 13では高水準演算と対応プラットフォームが前進し、企業導入の現実解が広がりました。関連ページはこちら:

-[マルチインスタンスGPU(MIG)とは?仕組みや注意事項・実務手順もご紹介]

-[GPUドライバーとは?NVIDIA GPUドライバーを徹底解説]

-[NVIDIA DGX Sparkとは?~超小型スパコンの誕生秘話~ スペックや強みもご紹介]

-[NVIDIA DGX Sparkとは?②~FP4×128GB統合メモリの実力~]]

-[NVIDIA DGX Sparkとは?③ デスク上の“データセンター”を実現するネットワークとソフトウェア]

公開日:

最終更新日: