目次

1.Network Operatorとは?

Network Operatorは、Kubernetesクラスタ内のネットワークコンポーネントの管理を簡素化し、展開プロセスを効率化する重要なソフトウェアツールです。これにより、組織はNVIDIAのネットワークリソースを効率的に管理できるようになり、AIや機械学習ワークロードなど、高性能ネットワークを必要とするアプリケーションに特に有益です。また、低遅延通信とデータ集約型環境でのスループット最大化に不可欠なRDMAやGPU Direct RDMAなどの高度な機能をサポートしています。

(1)NVIDIA Network オペレーターの概要

・Kubernetesクラスター内のネットワーク管理を自動化・簡素化するためのソフトウェアツール

・ネットワーク構成の展開プロセスが効率化され、運用負担が大幅に軽減

・組織はNVIDIA製のネットワーク機能を最適に活用できるようになる

(2)有効なユースケース

・AIや機械学習などの高負担ワークロードにおいて、高速かつ安定した通信が求められる環境に最適

・低遅延で高スループットな通信を実現し、データ転送性能を最大化

(3)対応する高度な機能

・RDMA(Remote Direct Memory Access):CPUを介さずにデータを直接転送

・GPUダイレクト:GPUメモリ間での高速通信を実現

・データ集約型アプリケーションに適した構成が可能

▼図1 Network Operatorとは?

これらの特長を活かすことで、AI/ML基盤の拡張時にもスムーズなスケーラビリティを確保できるため、今後のシステム設計やPoC段階での導入検討においても大いに注目すべきコンポーネントです。

2.実際のアプリケーションおよびユースケース

Network Operatorは、特にAIと機械学習ワークフローの強化において、さまざまな実世界アプリケーションで重要な役割を果たします。高速データ転送を可能にし、GPU Direct RDMA、クラウドネイティブ環境を活用して、トレーニングと推論ワークロードに不可欠な高速データ転送を実現します。また、高速化されたネットワークとRDMA接続をサポートし、効率的なデータ処理を確保できます。

さらに、エンタープライズとエッジ環境では、Kubernetesクラスタを効果的に管理するための高性能ネットワークソリューションを提供し、転送速度を大幅に向上させます。

ここで紹介した各ユースケースは、Network Operatorが最新のネットワーク課題に対応する柔軟性とパワーを実証します。

▼図2 Network Operatorのユースケース

これらのユースケースを通じて、Network Operatorは最新のAI・データインフラにおけるネットワーク課題を解決し、Kubernetesとの親和性を活かしてスケーラブルかつ高性能なネットワーク基盤を実現します。

3.クラウドネイティブの管理とオーケストレーション

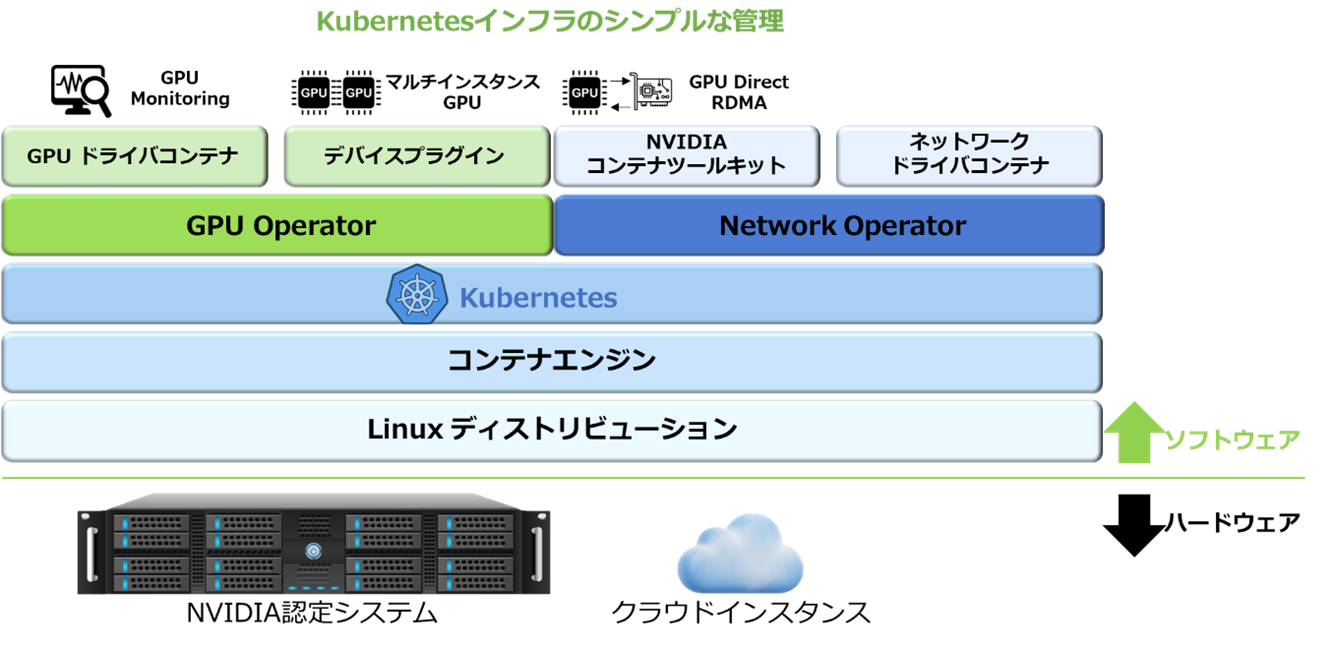

Kubernetesインフラストラクチャの効率的な管理に焦点を当て、GPU OperatorとNetwork Operatorの重要な役割を説明します。GPU Operatorは、Kubernetes上でGPUを提供するソフトウェアのライフサイクル管理を自動化するのに不可欠な存在です。これにより、パフォーマンスの向上だけでなく、利用率とテレメトリ機能の向上も実現します。

一方、Network Operatorは、RDMAやGPU Direct RDMAワークロードを実行するうえで重要な役割を担っており、NVIDIAのネットワークドライバーを活用することで高度な機能を引き出しています。図3は、これらのOperatorがKubernetesの様々なコンポーネントとどのように連携しているかを視覚的に示しており、クラウド環境におけるGPUおよびネットワークのオーケストレーションを強調しています。

この統合は、クラウドネイティブアプリケーションにおけるリソース管理とパフォーマンスの最適化に不可欠です。

▼図3 Kubernetes インフラのシンプルな管理

上図における、GPU OperatorおよびNetwork Operatorの役割について説明します。

GPU Operator

・Kubernetes上でGPUを利用可能にするために必要なソフトウェアのライフサイクル管理を自動化。

・GPUの性能、利用効率、テレメトリの向上など、より高度な機能を有効にする。

・業界をリードするKubernetesソリューションとの互換性について認証・検証済み。

Network Operator

・Kubernetesクラスタ上でのRDMAおよびGPU Direct RDMAワークロードの実行を支援。

・高度な機能を実現するNVIDIAネットワークドライバーを提供。

このように、これらのOperatorはクラウドネイティブなAI/MLアプリケーションやデータ集約型ワークロードにおける基盤を支える重要な役割を果たしています。

4.Network Operatorの主な機能とメリットについて

4-1.主な機能

Network Operatorの主要な機能を強調し、カスタムリソース定義とOperator SDKを通じてKubernetesとのシームレスな統合を説明します。この統合は、ネットワークコンポーネントを効果的に管理するために不可欠です。高度なネットワーク機能、特にRDMAとGPU Direct RDMAは、AIと機械学習ワークロードのパフォーマンス最適化に不可欠で、データ処理を高速化します。

さらに、ハードウェアリソース管理のためのKubernetesデバイスプラグインの使用により、高速ネットワーキングに必要なリソースが効率的に割り当てられます。

最後に、セカンダリネットワークのサポートは、ネットワーク集約型アプリケーションの処理に不可欠であり、要求の厳しいワークロードに対応するための柔軟性を提供します。

Kubernetesとの統合

Kubernetesのカスタムリソース定義(CRDs)およびOperator SDKを活用し、ネットワークコンポーネントを管理。

高度なネットワーク機能

高性能なAI/MLワークロードに不可欠なRDMAおよびGPU Direct RDMAを有効。

ハードウェアリソースの管理

高速ネットワーキングのために、Kubernetesのデバイスプラグインを利用してハードウェアリソースを提供。

セカンダリネットワークコンポーネント

セカンダリネットワークの構成により、ネットワーク負荷の高いワークロードをサポート。

4-2.メリット

Network Operatorは、ネットワークの管理とパフォーマンスを向上させる上で、いくつもの重要なメリットをもたらします。自動化が重要な役割を果たしており、ネットワークリソースのデプロイと設定を効率化することで、ヒューマンエラーの可能性を最小化し、手作業に費やす時間を削減します。

また、集中管理は大きな変革要素であり、ネットワークコンポーネント全体を一元的に制御することで、ネットワーク全体の一貫性を確保し、トラブルシューティングも簡素化されます。

さらに、高性能ネットワーキング機能は、スケールアウト型のGPUコンピューティングクラスタに特に有効で、必要なスループットと低レイテンシを実現します。

最後に、NVIDIA GPU Operatorとの互換性は不可欠であり、GPU Direct RDMAによるデータ転送とパフォーマンスを適合システム上で実現します。

これらの利点により、Network Operatorは最新のネットワークインフラにおいて欠かせないツールとして位置付けられています。

自動化:ネットワークリソースの展開と構成を自動化し、手作業の負担やエラーを削減。

集中管理:すべてのネットワークコンポーネントを管理するための一元的な管理ポイントを提供し、一貫性を高めトラブルシューティングを簡素化。

高性能ネットワーキング:スケールアウトGPUコンピューティングクラスタ向けに、高スループット・低遅延のネットワークを実現。

GPU Operatorとの互換性:NVIDIA GPU Operatorと連携して、対応システム上でGPU Direct RDMAを有効化。

Network Operatorは高度なAIネットワークインフラに不可欠な存在であり、これらの利点により、Network Operatorは、AIや高性能コンピューティングを支える最新のネットワークインフラの中核的な存在となっています。

5.Network Operatorのデプロイと管理

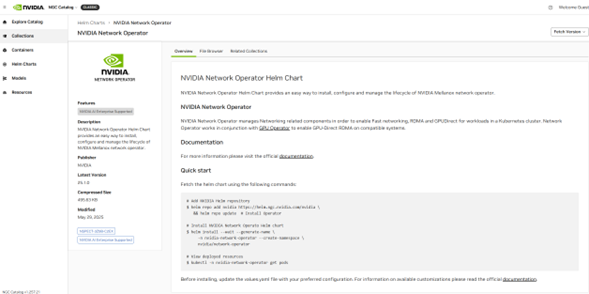

Network Operator の展開と管理の側面に焦点を当てると、Helmチャートを利用することで、Kubernetesクラスタ内でのデプロイプロセスが簡素化され、ユーザーにとってより扱いやすくなります。さらに、このソフトウェアは、Apache 2.0ライセンスの下でオープンソースとして提供されているため、コミュニティによる貢献が促進されるだけでなく、特定のニーズに合わせて幅広くカスタマイズすることも可能です。

また、「分散IPアドレス管理プラグイン(Whereabouts)や NVIDIA IPAM」といった IP アドレス管理(IPAM)プラグインのサポートにより、ネットワークの整合性を維持するために重要な IP 管理の効率が向上します。

Network Operatorのインターフェース画面を示す図は、ユーザーが利用できるメインメニューやドキュメントリソースを紹介しており、その機能性を具体的にイメージするのに役立ちます。

▼図4 Network Operatorのデプロイ方法

詳細なドキュメントの内容については、こちらをご参照ください。

6.まとめ

Network Operatorについて説明してきましたが、Network Operatorを利用することで、Kubernetesクラスタ上でのネットワークコンポーネントの管理と最適化を支援します。AI/MLワークロードに不可欠な高速ネットワーキング、RDMA(リモートダイレクトメモリアクセス)、GPU Direct RDMAを容易に導入でき、NVIDIA のネットワークリソース(ドライバやプラグイン)を統合管理します。次回は、推論サービスを効率的に管理する「NVIDIA NIM Operator」をテーマに、AI運用の新たなステージについて解説します。

さらに理解を深めたい方は、以下の関連記事もぜひご覧ください。

関連記事はこちら:

-[Kubernetesとは?初心者向けに分かりやすく解説]

-[KubernetesでAIをもっと簡単にーNVIDIA Operatorsが変えるAI運用【GPU Operator編】]

【筆者情報】

菱洋エレクトロ株式会社 ソリューション事業本部

小宮敏博

公開日:最終更新日: