こんにちは!前回のNVIDIA AI Enterpriseコラムでは、NVIDIA AI Enterprise(以下NVAIEと省略)の概要をご紹介しました。

今回はNVAIEのソフトウェアおよびインフラストラクチャについてお話します。

また、NVIDIA NIMの豊富なマイクロサービスから選択し、最先端の基盤モデルと推論モデルの効率的な推論を実現できます。 さらにNVIDIA NeMoツールを活用して、データ処理、モデルのカスタマイズ、システム評価、検索、拡張生成、ガードレールを効率化できます。

NVIDIA Blueprintsは、数多くのAIアプリケーション向けの参照ワークフローを提供し、ご自身のニーズに合わせて適応可能です。

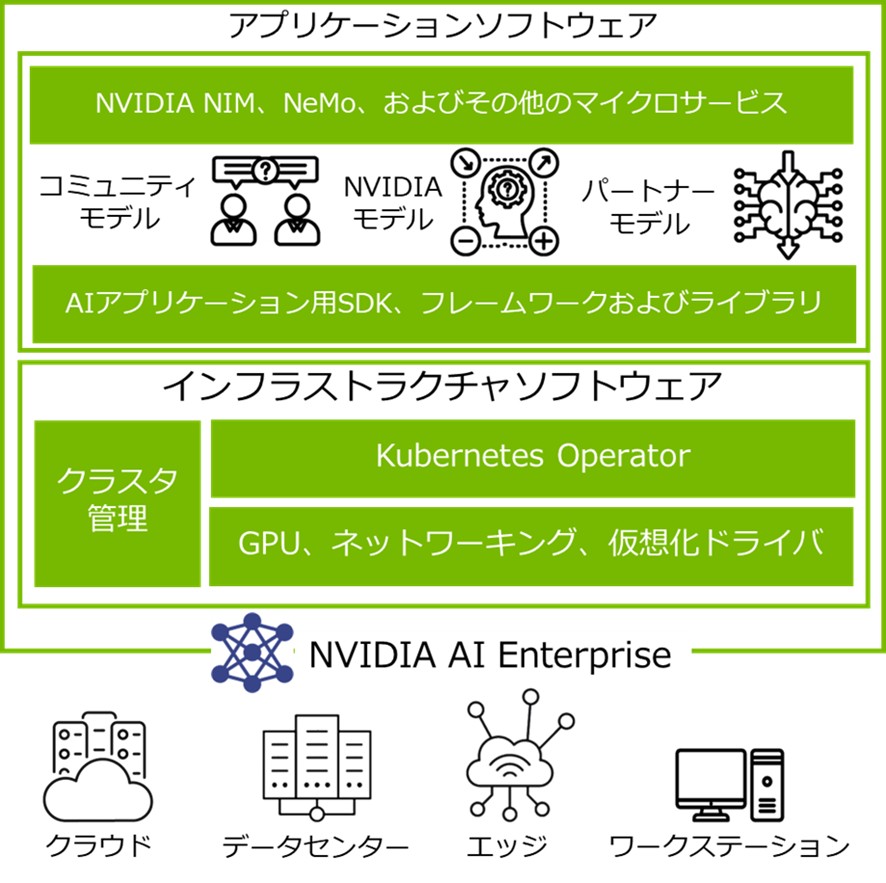

▼図1 AIエージェントの基盤の概要

これにより、AIエージェントの迅速かつ大規模な構築・展開を強力に支援します。

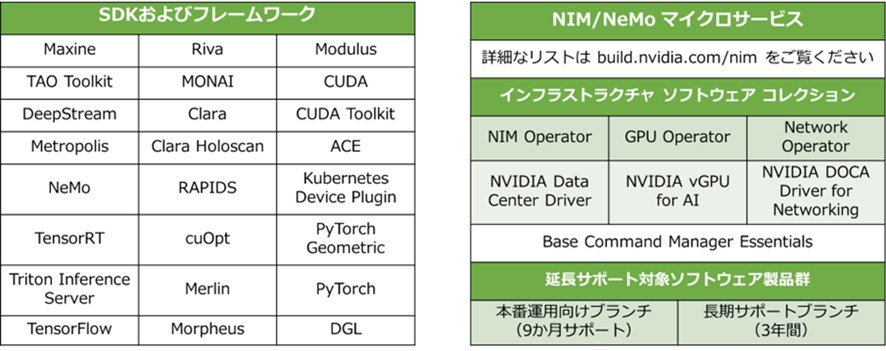

▼図2 NVAIE対応ソフトウェア

これらは2種類のカテゴリに分類されます。内容については以下に記載します。

AIインフラを構築・運用する顧客は、必要なコンポーネントを自由に組み合わせられます。

これにより、開発から本番まで移行がシームレスになり、データ主権やセキュリティを守りつつ、どこでもAIの価値を最速で実現できます。

では、オンプレミス環境で動作する場合について、ご説明します。

▼図3 NVIDIA認定システムについて

一言でいうと、「NVIDIAが性能・信頼性・安全性を保証したサーバーやワークステーション」になります。 主要メーカー(HPE、DELL、Supermicroなどが)製造するサーバーやワークステーションに、NVIDIAのGPUとネットワークを組み込み、厳格なテストを通じて「これならAI・データ分析に最適」と認められたものです。

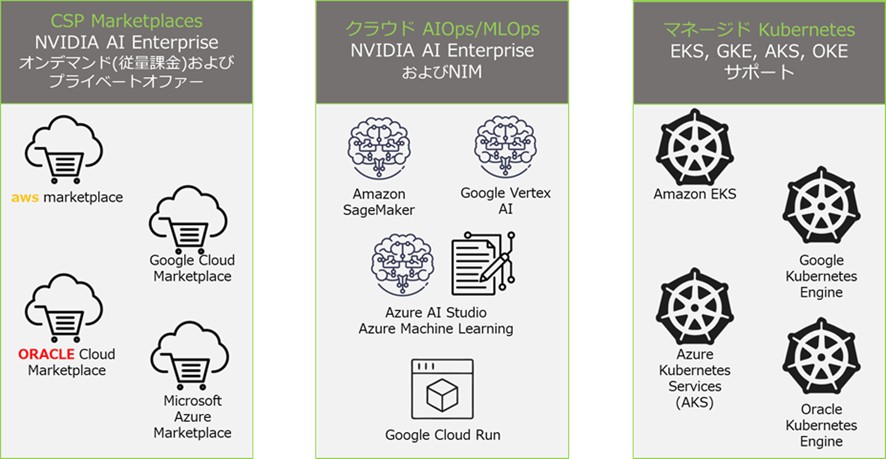

▼図4 NVAIEとCSP統合について

Run Anywhereは、データセンター、クラウド、エッジ、ワークステーションに同じスタックを展開可能です。

生成AIの導入をご検討の際は、ぜひNVIDIA AI Enterpriseをご活用ください。

詳細は以下をご参照ください:

▶お問い合わせはこちら

今回はNVAIEのソフトウェアおよびインフラストラクチャについてお話します。

1.AIエージェントの基盤について

AIエージェントは、さまざまな種類のデータを扱い、音声や画像など複数のモダリティにまたがって人間のように動作する必要があります。企業はこうしたAIエージェントの機会を大規模に活用する準備が整っており、1~2個のユースケースにとどまらず、企業全体の中核的な能力を大規模に解き放つことに注力しています。そのような基盤を構成するにあたり、NVIDIA AI Enterprise(以下、NVAIE)は非常に便利です。 包括的なモジュール式プラットフォームを通じて、エージェント型AIの開発と展開を促進します。このプラットフォームは、お客様の技術スタック、エンタープライズ知識ベース、およびユースケースに連携し適応します。また、NVIDIA NIMの豊富なマイクロサービスから選択し、最先端の基盤モデルと推論モデルの効率的な推論を実現できます。 さらにNVIDIA NeMoツールを活用して、データ処理、モデルのカスタマイズ、システム評価、検索、拡張生成、ガードレールを効率化できます。

NVIDIA Blueprintsは、数多くのAIアプリケーション向けの参照ワークフローを提供し、ご自身のニーズに合わせて適応可能です。

▼図1 AIエージェントの基盤の概要

これにより、AIエージェントの迅速かつ大規模な構築・展開を強力に支援します。

2.NVAIE対応ソフトウェアについて

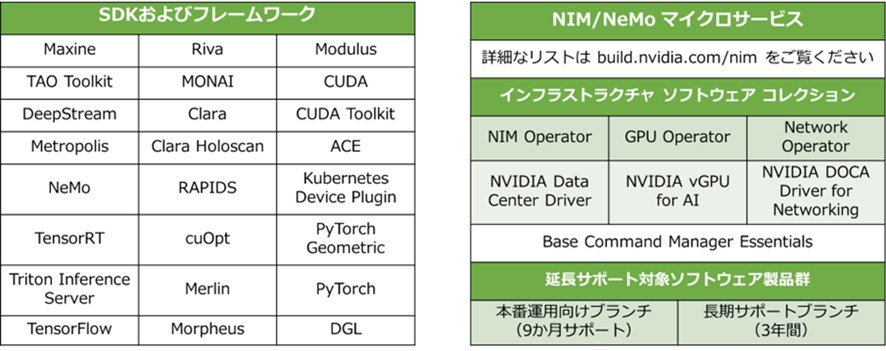

NVAIEは、ほぼすべてのAIユースケースに対応するSDKとフレームワークを提供します。また、Kubernetesオーケストレーションプラットフォーム上で、ベアメタルまたは仮想化環境で実行する場合にも、これらのソリューションを展開・管理するための必須ソフトウェアが含まれます。詳細はNVIDIA社が提案するNVIDIA NGC カタログをご参照ください。▼図2 NVAIE対応ソフトウェア

これらは2種類のカテゴリに分類されます。内容については以下に記載します。

アプリケーションソフトウェア

以下3つのコンポーネントで構成され、必要なものを選んでAIパイプラインを構築できます。| コンポーネント | 内容 |

| NIM&NeMoマイクロサービス | 最適化済み推論/カスタマイズ用サービスにより、生成AIのモデル性能とデプロイ速度を向上 |

| AIモデルカタログ | NVIDIA社およびパートナーコミュニティが提供する、あらゆるドメイン向け事前学習済みモデル |

| SDKフレームワークライブラリ | 音声AI、経路最適化、サイバーセキュリティ、Vision AIなど多数の領域を網羅 |

インフラストラクチャソフトウェア

| 機能 | 内容 |

| Kubernetes Operator | GPU・ネットワークの管理、マイクロサービス/AIパイプラインのライフサイクル運用 |

| クラスタ管理ソフトウェア | 大規模サーバーのプロビジョニングとモニタリング |

| GPU&ネットワーキングドライバ | ベアメタルおよび仮想環境でのリソース最適化 |

AIインフラを構築・運用する顧客は、必要なコンポーネントを自由に組み合わせられます。

3.NVAIEが動作するインフラストラクチャについて

NVAIEは「Run Anywhere」をコンセプトに、クラウド・データセンター・エッジ・ワークステーション、どこにでも同じAI環境を展開できます。これにより、開発から本番まで移行がシームレスになり、データ主権やセキュリティを守りつつ、どこでもAIの価値を最速で実現できます。

では、オンプレミス環境で動作する場合について、ご説明します。

▼図3 NVIDIA認定システムについて

NVIDIA認定システムに対応

NVAIEは、NVIDIA認定システムで動作が保証されています。 NVIDIA認定システムと言われてもよくわからない人が多いと思いますので、簡単にNVIDIA認定システムとは何かご説明します。一言でいうと、「NVIDIAが性能・信頼性・安全性を保証したサーバーやワークステーション」になります。 主要メーカー(HPE、DELL、Supermicroなどが)製造するサーバーやワークステーションに、NVIDIAのGPUとネットワークを組み込み、厳格なテストを通じて「これならAI・データ分析に最適」と認められたものです。

NVIDIA認定システムの特長

- 性能が保証されている:NVIDIAが設計するベストプラクティスに沿って検証済み 、マルチGPU構成、MIG(マルチインスタンスGPU)でも安定稼働

- 幅広い用途対応:小規模~大規模までスケール可能。AI推論、データ分析、映像解析に対応

- 主要ソフトウェアと統合:VMware vSphere、Red Hat OpenShift、Kubernetesなどとシームレスに統合

- セキュリティ対策:プラットフォーム、ネットワーク、アプリケーション各レイヤーで保護、そのため、データセンターでもエッジ(拠点サーバー)でも安心して利用可能

なぜNVIDIA認定が必要なのか?

一般的なサーバーやPCにGPUを載せるだけでは、AIやデータ分析を本格的に運用する際に以下のような懸念事項があります。- 性能が出ない

- 障害起きやすい

- セキュリティに不安が残る

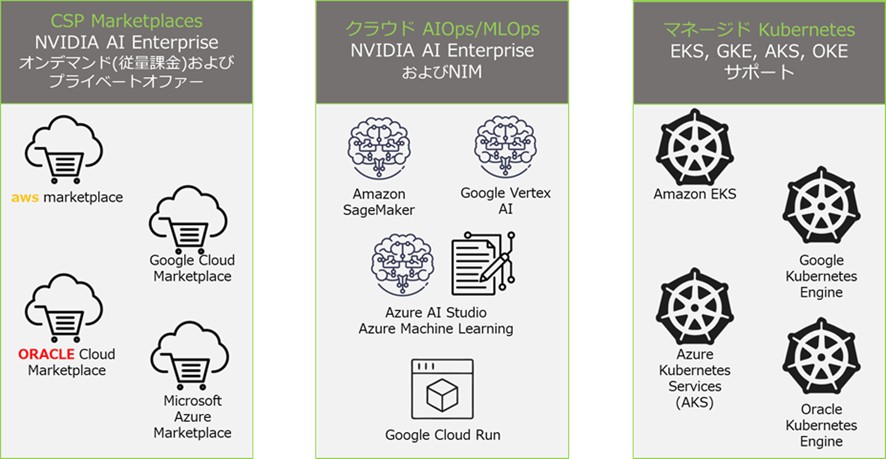

4.NVAIEおよびNIMのCSP統合

NVAIEのソフトウェアは、主要なハイパースケールクラウドサービスプロバイダーのマシンプラットフォームに統合されています。 ソフトウェアがプリロードされたイメージは、CSPマーケットプレースで利用可能となります。 ソフトウェア(NIMマイクロサービスを含む)は、各社のAIOpsおよびMLOpsツールと統合されており、クラウド管理型Kubernetesシステムでもサポートされています。▼図4 NVAIEとCSP統合について

5.まとめ

今回の内容および前回のブログ内容を含めて、以下にNVAIEについてまとめてみました。 本記事で紹介したNVAIEの主要ポイントは以下の通りですアプリケーションレイヤ

- NVIDIA NIM(Inference Microservices):推論用マイクロサービス(NVIDIAが事前最適化したLLM・生成AIをAPI経由で呼び出し) 、標準REST API、業界標準フォーマット

- NVIDIA NeMo:トレーニング・評価・カスタマイズ・ガードレール(安全性)までカバー 、RAG(検索拡張生成)ワークフローもここで構築可能

- NVIDIA Blueprints:研究支援/カスタマーサポート/セキュリティ監視/ビジョン解析などのリファレンスワークフロー

- AI&データサイエンスカタログ:NVIDIA/パートナー/OSSコミュニティモデルを収録し、多分野のSDK/ライブラリ提供

インフラストラクチャレイヤ

- Kubernetes Operators:GPU・ネットワークリソースをPod単位で管理、NIMやNeMoのライフサイクル制御

- クラスタ管理:大規模ノード群をプロビジョニング+監視

- ドライバ群:NVIDIA GPUドライバ・ネットワーキングドライブをベアメタル/仮想化(VMware, KVM)両方に提供

- NVIDIA NGC™ カタログからの取得:すべてのコンテナ、オペレーター、ツールをNGC(NVIDIA GPU Cloud)から入手

セキュリティ&運用設計

- Resilient(レジリエント)ソフトウェア:リリース時に脆弱性を考慮した設計

- Continuous Protection:API互換性を保ちながら定期パッチ・アップデート

- Rapid Response:新規脅威へ迅速な対応

リファレンスアーキテクチャ・ドキュメント

- リファレンス アーキテクチャ:VMware vSphere, OpenShift(ベアメタル環境またはvSphere上)における具体構築例

- サイジングガイド:GPUあたりの推奨ワークロード規模(例:LLM推論でのトークン秒、画像認識でのバッチサイズ)、および環境ごとのメモリ・ストレージ要件(オンプレミス/クラウド両対応)

- 導入ガイド:環境要件(CPU、RAM、NIC)、ネットワーク構成例、クラスタ構築例(VMware vSphere環境、OpenShift環境それぞれの推奨構成例を含む)。

サポート&運用

- NVIDIA SLA付きサポート:8~17時、もしくは24時間365日サポート(オプション) 、テクニカルアカウントマネージャーによるプロアクティブサポート

- 優先通知:セキュリティパッチ、パートナー連携アップデートを先行通知

- 単一ライセンスモデル:1GPU単位で料金統一(H100などのは機種不問)、NIM/NeMo含むすべての最新機能が随時利用可能

導入の技術的なポイント

- マルチテナンシー/MIG:H100/H200等でMIG分割を利用し、複数AIパイプラインを単一GPU上で運用

- クラウド統合:Azure Marketplace等でプリインストールAMIを提供。EKS/GKE/AKS等のK8sとも統合

- ハイブリッド環境:VMware vSphere with Tanzu、Red Hat OpenShift(K8s)基盤に対応し、オンプレからクラウドまで共通運用可

Run Anywhereは、データセンター、クラウド、エッジ、ワークステーションに同じスタックを展開可能です。

生成AIの導入をご検討の際は、ぜひNVIDIA AI Enterpriseをご活用ください。

詳細は以下をご参照ください:

- OpenShift on Bare Metal Deployment Guide

- OpenShift on VMware vSphere Deployment Guide

- NVIDIA AI Enterprise Reference Architecture

- NVIDIA AI Enterprise Sizing Guide

▶お問い合わせはこちら

公開日:最終更新日: