productNVIDIA

H100 Tensor Core GPU 80GB

あらゆるデータセンターにかつてない性能、拡張性、セキュリティを提供

H100 Tensor Core GPU 80GB

NVIDIA H100 Tensor Core GPU 80GBは、NVDIA Hopperアーキテクチャを採用し、80GBの大容量メモリーを搭載したデータセンター向けGPUです。

大規模言語モデルに最大のパフォーマンスを発揮します。

特長

アクセラレーテッド コンピューティングの大きな飛躍

NVIDIA H100 TensorコアGPU で、あらゆるワークロードのためのかつてない性能、拡張性、セキュリティを手に入れましょう。NVIDIA NVLink Switch Systemにより、最大256個のH100を接続し、エクサスケールのワークロードを高速化できます。さらに、専用のTransformer Engineを利用することで、パラメーターが兆単位の言語モデルを実装できます。H100の複合的な技術革新により、大規模な言語モデルが前世代と比較して30倍も高速化され、業界の一歩先を行く対話型AIが可能となります。前世代のTensor行列演算と比較して2倍以上のスループットを実現するFine-Grained Structured Sparsity機能をサポートしています。Tensorコアのアップデートは、新しいFP8精度モードを高速化します。独立した浮動小数点と整数のデータパスにより、計算とアドレッシング計を組み合わせてワークロードをより効率的に実行できます。

大規模言語モデル推論を加速

最大1750億パラメーターの大規模言語モデル(LLM)の場合、PCIeベースのH100 NVL with NVLinkブリッジは、Transformer Engine、NVLink、および188GB HBM3メモリーを利用して、あらゆるデータセンターで最適な性能と容易な拡張性を提供し、LLMを主流にしています。H100 NVL GPUを搭載したサーバーは、電力制約のあるデータ センター環境において低遅延を維持しながら、GPT-175Bモデルの性能をNVIDIA DGX A100システムの最大12倍まで向上します。NVIDIA CUDAコア

単精度浮動小数点(FP32)演算の倍速処理により、デスクトップにおける複雑な3Dのコンピューター支援設計(CAD)とコンピューター支援エンジニアリング(CAE)などのグラフィックスやシミュレーションのワークフローに適した驚異的なパフォーマンス向上を実現します。NVIDIA AI Enterprise

標準サーバー向けのH100には、NVIDIA AI Enterpriseソフトウェア スイートのサブスクリプション5年分(エンタープライズサポートなど)が付属しており、その非常に優れた性能によってAIを簡単に導入できます。それにより、企業や組織は、AIチャットボット、レコメンデーション エンジン、ビジョンAIなど、H100で高速化するAIワークフローを構築するために必要なAIフレームワークおよびツールが活用できるようになります。第4世代 Tensorコア

ディープラーニングの行列乗算と積和演算に特化した第4世代Tensorコアは、より多くのデータ型を高速化し、前世代のTensor行列演算と比較して2倍以上のスループットを実現するFine-Grained Structured Sparsity機能をサポートしています。Tensorコアのアップデートはまた、新しいFP8精度モードを高速化します。独立した浮動小数点と整数のデータパスにより、計算とアドレッシング計を組み合わせてワークロードをより効率的に実行できます。NVIDIA Omniverse Enterprise

3Dパイプラインと仮想世界の接続、構築、運用

現実に忠実な3Dアセットや3D環境の設計から、大規模なデジタルツインの運用まで、NVIDIA Omniverse EnterpriseとUniversal Scene Description(OpenUSD)を利用すれば、物理的に正確な大規模シミュレーションや処理能力要求の高いAI、産業、科学ワークフローの課題などをチームは克服できます。

NVIDIA AI Enterprise詳細ページ

製品情報

| 製品名 | NVIDIA H100 Tensor Core GPU 80GB |

| 型番 | NVH100-80G |

| JANコード | なし |

| 価格 | オープンプライス |

| 同梱物 | 保証書 ※補助ケーブルは付属しません |

仕様

| 項目 | 内容 |

|---|---|

| アーキテクチャ | Hopper |

| GPUメモリー | 80GB HBM2e |

| メモリー帯域幅 | 2TB/s |

| エラー修正コード(ECC) | 対応 |

| FP64 | 26TFLOPS |

| FP64 Tensor Core | 51TFLOPS |

| FP32 | 51TFLOPS |

| TF32 Tensor Core | 756TFOLPS* |

| BFLOAT16 Tensor core | 1,513 TFLOPS* |

| FP16 Tensor Core | 1,513 TFLOPS* |

| FP8 Tensor Core | 3,026 TFLOPS* |

| INT8 Tensor Core | 3,026 TFLOPS* |

| NVIDIA NVLINK | 対応 |

| デコーダー | 7xNVDEC 7xJPEG |

| インターコネクト | PCIe5.0:128GB/s NVLink:600GB/s |

| 消費電力(TDP) | 300~350W |

| 冷却機構 | パッシブ |

| フォームファクター(mm) | 高さ111x長さ267.7 Dual Slot |

| マルチインスタンスGPU(MIG) | 10GBのMIGが最大7つ |

| 付属ライセンス | NVIDIA AI Enterprise 5年Subscriptionライセンスが付属 |

| 同梱物 | 保証書 ※補助ケーブルは付属しません |

*sparsity有効時

オプション/保証

<製品保証>保証対象製品の交換(センドバック方式)

※ ユーザー起因はこの限りではありません

※ 交換後の保証期間は、元の保証期間の残存期間が適用されます

※ 仕様などは予告なしに変更されることがあります

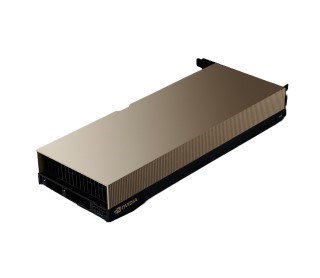

外観

|

|