productNVIDIA

DGX SuperPOD/BasePOD

世界初のすぐに使えるAIデータセンター

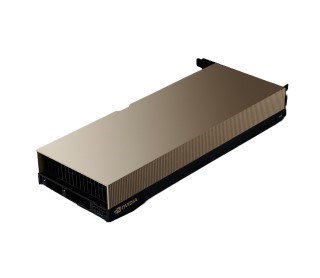

DGX SuperPOD/BasePOD

NVIDIA DGX SuperPOD/BasePODは、IT部門があらゆるユーザーとワークロードに妥協のないパフォーマンスを提供できるようにする、オンプレミスやハイブリッドにも展開可能な業界トップクラスのAIインフラストラクチャです。

NVIDIA DGXプラットフォームは、きわめて困難なAIワークロードに対して、最高クラスのアクセラレーテッド インフラとスケーラブルなパフォーマンスを提供しており、業界で評価されています。

特長

NVIDIA DGX H100システムを搭載

NVIDIA DGX H100システムを搭載したDGX SuperPODは、NVIDIA NeMoフレームワークによる大規模な言語モデルやディープラーニングによるレコメンダーシステムなど、大規模かつ高度に複雑な、あるいはトランスフォーマベースのAIワークロードをサポートするスケーラブルなインフラに最適です。Aテストおよび実証済みのDGX SuperPOD

DGX SuperPODは、パフォーマンスおよび信頼性に対するエンタープライズのニーズを満たす、予測性の高いソリューションです。NVIDIAは、DGX SuperPODを広範にテストし、企業におけるAIワークロードの要求に対応できるまでその性能を高めているため、アプリケーションのパフォーマンスに関して心配する必要はありません。常に進化する高度なインフラ ソフトウェア

DGX SuperPODは、AIワークフロー管理、コンピューティング、ストレージ、ネットワークインフラを高速化するライブラリ、AIワークロードに最適化されたオペレーティングシステムを含む実証済みのソフトウェアであるNVIDIA Base Commandを採用しています。NVIDIA Base Command Managerによるシンプルな管理

NVIDIA Base Command Managerにより、DGX SuperPODのデプロイ、ソフトウェアプロビジョニング、継続的な監視、正常性チェックをシームレスに自動化します。専門家による専任サポートと特化型サービス

DGX SuperPODでは、専任の専門家が、導入からインフラ管理、ワークロードの拡張や本番AIの合理化まで、すべてを支援します。AIに精通したメンバーで構成される世界最大のチームに直接相談できる「DGXpert」もご利用いただけます。構成

◆ NVIDIA H100 GPUx8、合計GPUメモリー 640GBGPUあたり12NVIDIA NVLINKs、GPU間の双方向帯域幅900GB/s

◆ NVIDIA NVSWITCHESx4

7.2TB/sのGPU間双方向帯域幅 、前世代比1.5倍以上

◆ NVIDIA CONNECTX-7 x8 および、NVIDIA BLUEFIELD DPU 400Gb/s ネットワークインターフェース x2

ピーク時の双方向ネットワーク帯域幅 1TB/s

◆ デュアル x86 CPUと2TBシステムメモリー

AIへの依存が非常に高い仕事を可能にするパワフルなCPU

◆ 30TB NVME SSD

最高のパフォーマンスを実現するための高速ストレージ

仕様

| 項目 | 内容 |

|---|---|

| GPU | 8xNVIDIA H100 TensorコアGPU |

| GPUメモリー | 合計640GB(各80GBx8) |

| パフォーマンス | 32petaFLOPS FP8 |

| NVIDIA NVSwitch数 | 4 |

| システム消費電力 | 最大10.2kW |

| CPU | Dualx86 |

| システムメモリー | 2TB |

| ネットワーク | 4 個のOSFPポートで8基のシングルポートConnectX-7へ接続 400Gb/s InfiniBand/Ethernet 2基のデュアルポートNVIDIA BlueField-3 DPU VPI 400Gb/s InfiniBand/Ethernet x1 200Gb/s InfiniBand/Ethernet x1 |

| 管理ネットワーク | 10Gb/s オンボードNIC(RJ45 付き) 50Gb/s EthernetオプションNIC ホストベースボード管理コントローラー(BMC)(RJ45 付き) 2x NVIDIA BlueField-3 DPU BMC(それぞれRJ45コネクターで接続) |

| ストレージ | OS:2x1.9TB NVMe M.2 内部ストレージ:8x3.84TB NVMe U.2 |

| システムソフトウェア | DGX H100システムにプレインストールされているDGX OSは、Ubuntu Linuxをベースとし、 DGXソフトウェアスタック(DGX 用に最適化されている、必要なすべてのパッケージとドライバー)が含まれます。 オプションで、お客様がUbuntu LinuxまたはRed Hat Enterprise Linux、 および必要なDGXソフトウェアスタックを個別にインストールすることもできます。 |

| 動作温度範囲 | 5℃~30°C |

| フォームファクター(mm) | 356x482.2x897.1 |

ご購入

本製品は、メーカーのパートナー制度を活用した販売制度にて販売しております。※ 弊社から直販ではなく、NPNパートナー様(NVIDIA認定2次代理店)を介しての販売となります。

NPNパートナー様のご紹介やDGXを含めたNVIDIA製品についてのお問い合わせも承っておりますのでお気軽にお問い合わせください。